24年2月进展

第一篇文献

End-to-End Object Detection with Transformers

解决的问题

本文旨在提出一个新的图像检测框架,以完成对大规模数据集下的多物体图像检测(甚至包括全景分割)。

主要内容

本文有至少三个创新点,分别予以叙述。

创新点一:损失函数

检测框架的损失函数一般包括两部分,即分类误差和检测误差,然后使用超参数正则化为同一个损失函数。本文的损失函数在两点上作修改以适应当前的检测任务,其一是将交叉熵函数(对数形式)改为非对数的普通项(经验表明在当前模型条件下有着更好的检测结果);其二是在检测框损失函数上,同时使用了损失和交集损失并正则化,论文“Generalized intersection over union”保证了该正则化结果在检测上更有效。

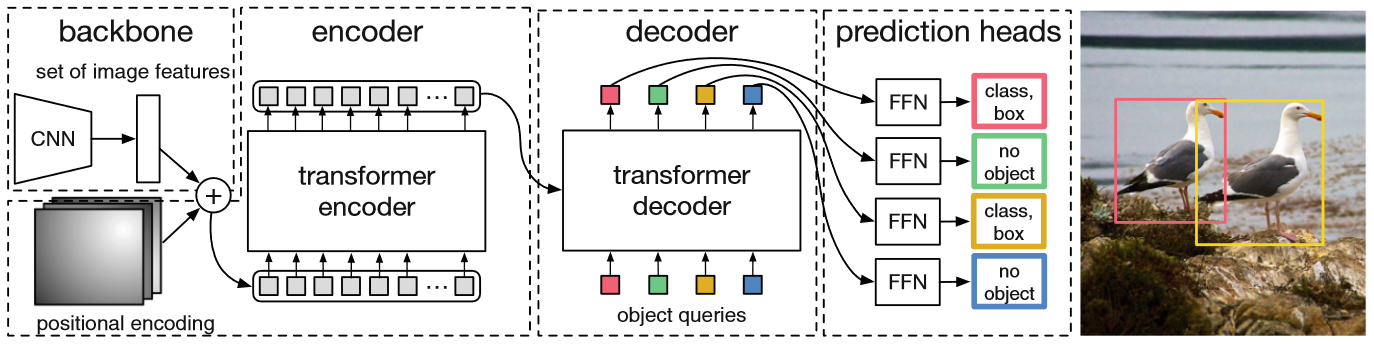

创新点二:网络架构

将Transformer和CNN结合的网络有不少,本文基本上是最早提出将基于CNN生成的图像特征与与Transformer的位置编码结合的,结合方式特殊在于:CNN提取出的网络特征有2048个维度,本文使用卷积将其减少为某一值,然后按文献Attention Augmented Convolutional Networks的方法将特征图和位置编码融合,可采用的是直接拼接。

在Transformer的解码器计算完毕后,后部加入一个简单前馈网络以完成框中心、宽高的预测。

创新点三:局部Loss

在论文原文中称为“附加Loss”,是在Transformer的解码器训练中单独增加了一个Loss函数以加快解码器生成的结果得到正确的分类。

框架评价

本文提出的DETR框架确实结合了CNN的特征空间和Transformer的语义空间两大优势,能够在更加复杂的环境中(如重叠,背景物体较多)仍然得到较好的检测结果,同时加入共享的前馈神经网络直接求解检测框的空间位置,前馈网络和CNN网络都比较轻量级,便于模型的部署。同时,各个模块之间的独立设计极大地方便了后续研究的深入(可以拆开一个模块单独尝试)。

本文的位置编码和特征融合方式值得借鉴。

第二篇文献

3D Semantic Segmentation with Submanifold Sparse Convolutional Networks

解决的问题

本文严格意义上并不是我想要的事件流稀疏卷积,不过参考自文献Event-based Asynchronous Sparse Convolutional Networks,至少ETH团队是这么干过(虽然效果不好),用于解决事件流在直接卷积过程中稀疏比例过高导到的计算效率低下问题。

主要内容

本文使用的稀疏卷积方法被称为“子流形稀疏卷积(Submanifold Sparse Convolution),其主要的思想是,使用哈希表和规则表的联合操作,将感兴趣的区域内的活跃位置(active)的值进行卷积,而忽略不活跃的位置,从而实现对稀疏性质的利用。

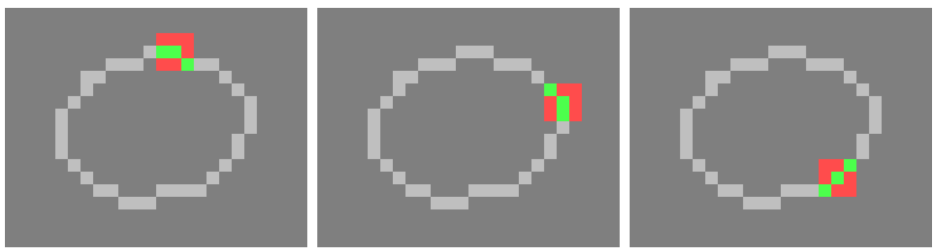

文中的活跃与不活跃定义来自于概念静态值(ground state),即在某一个输入矢量的作用下,有相当大的一些区域位置的值是基本不变的(这些值不一定就是零),只有少数几个位置的值会因输入而产生变化,这些位置就是活跃位置。如下图所示,用红色标注出来的位置是不itkt活跃位置,而绿色标注的位置是活跃位置。

在实际的算法设计中,作者保留了接口分别是输入维度、输出维度、两倍填充值(奇数)和通道数。

内容评价

本文使用的子流形稀疏卷积对稀疏性的掌握来自于卷积结果的局部不变,因此是从输出反作用至输入上的,有一点点凑结果的嫌疑,不过它毕竟原来是用在LiDAR的点云处理上的,强行套在事件流上也不能不说是一种凑,初步感觉还达不到想像中的真稀疏操作。